谷歌研究人員已經確定了針對現實世界人工智能系統可能發生的六種特定攻擊,發現這些常見的攻擊向量表現出獨特的復雜性,他們指出,這需要結合對抗性模擬和人工智能主題專業知識的幫助來構建堅實的防御。

該公司在本周發布的一份報告中透露,其專門的 AI 紅色團隊已經發現了對快速發展的技術的各種威脅,主要是基于攻擊者如何操縱驅動 ChatGPT、Google Bard 等生成式 AI 產品的大型語言模型 ( LLM )。

谷歌人工智能紅隊:道德黑客讓人工智能更安全

https://blog.google/technology/safety-security/googles-ai-red-team-the-ethical-hackers-making-ai-safer/

這些攻擊很大程度上導致技術產生意外甚至惡意驅動的結果,這可能會導致像普通人的照片出現在名人照片網站上一樣良性的結果,但會導致更嚴重的后果,例如規避安全的網絡釣魚攻擊或數據盜竊。

谷歌的調查結果是在其發布安全人工智能框架(SAIF)之后發布的,該公司表示,該框架的目的是在為時已晚之前解決人工智能安全問題,因為該技術已經被快速采用,并隨之產生了新的安全威脅。

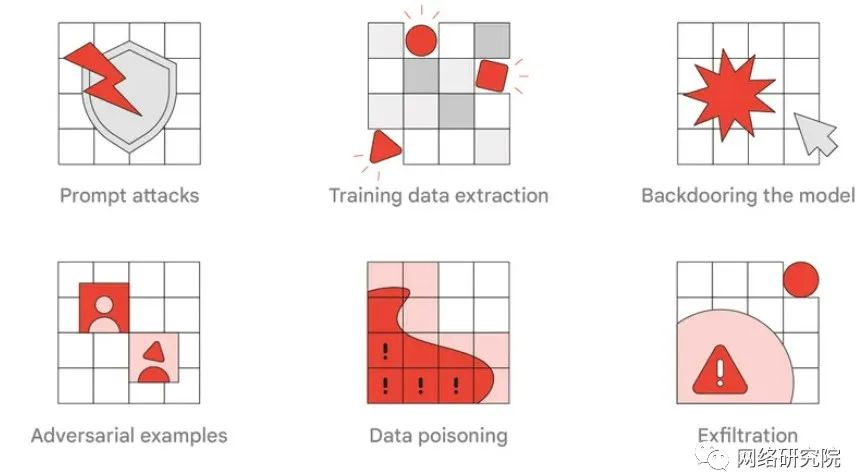

現代人工智能系統的 6 種常見攻擊

Google 識別的第一組常見攻擊是即時攻擊,其中涉及“即時工程”。這個術語指的是制定有效的提示來指導法學碩士執行所需的任務。研究人員表示,這種對模型的影響如果是惡意的,可能會以非預期的方式惡意影響基于 LLM 的應用程序的輸出。

一個例子是,如果有人在基于人工智能的網絡釣魚攻擊中添加了一個段落,該段落對最終用戶來說是不可見的,但可以指示人工智能將網絡釣魚電子郵件分類為合法。這可能會使其繞過電子郵件反網絡釣魚保護,并增加網絡釣魚攻擊成功的機會。

該團隊發現的另一種類型的攻擊稱為訓練數據提取,其目的是重建模型使用的逐字訓練示例,例如互聯網的內容。通過這種方式,攻擊者可以從數據中提取秘密,例如逐字個人身份信息 (PII)或密碼。研究人員寫道:攻擊者被激勵以個性化模型或經過包含 PII 數據訓練的模型為目標,以收集敏感信息。

第三種潛在的人工智能攻擊是模型后門,攻擊者“可能試圖秘密改變模型的行為,以使用特定的‘觸發’詞或特征(也稱為后門)產生不正確的輸出,在這種類型的攻擊中,威脅參與者可以在模型或其輸出中隱藏代碼以進行惡意活動。

第四種攻擊類型稱為對抗性示例,是攻擊者向模型提供的輸入,以產生“確定性但高度意外的輸出”。一個例子是,模型可以顯示一幅圖像,該圖像在人眼中清楚地顯示出一件事,但模型將其完全識別為另一件事。這種類型的攻擊可能是相當良性的(在這種情況下,有人可以訓練模型將他或她自己的照片識別為值得包含在名人網站上的照片),也可能是至關重要的,具體取決于技術和意圖。

攻擊者還可以利用數據中毒攻擊來操縱模型的訓練數據,從而根據攻擊者的偏好影響模型的輸出,如果開發人員使用人工智能幫助他們開發軟件,這也可能威脅軟件供應鏈的安全。這種攻擊的影響可能類似于模型后門。

谷歌專門的人工智能紅隊識別的最后一種攻擊類型是滲透攻擊,攻擊者可以復制模型的文件表示形式以竊取存儲在其中的敏感知識產權。然后,他們可以利用這些信息來生成自己的模型,該模型可用于為攻擊者提供定制攻擊中的獨特功能。

傳統安全很重要

谷歌最初的人工智能紅隊演習為研究人員提供了一些寶貴的經驗教訓,其他企業也可以利用這些經驗教訓來防御對人工智能系統的攻擊。第一個是,雖然紅隊活動是一個良好的開端,但組織還應該與人工智能專家合作,進行現實的端到端對抗模擬,以實現最大程度的防御。

事實上,紅隊演習(即組織招募道德黑客團隊嘗試滲透其自身系統以識別潛在漏洞)正在成為幫助企業增強整體安全態勢的流行趨勢。

我們相信,紅隊將在每個組織應對人工智能系統攻擊的準備中發揮決定性作用,并期待共同努力幫助每個人以安全的方式利用人工智能。

然而,團隊從另一個教訓中得到了一些好消息:傳統的安全控制可以有效、顯著地降低人工智能系統的風險。

對于保護人工智能模型在其整個生命周期的完整性以防止數據中毒和后門攻擊來說尤其如此。

與傳統企業系統中的所有其他資產一樣,組織還應確保系統和模型得到正確鎖定,以防御人工智能攻擊。

此外,研究人員指出,組織可以使用與嗅探傳統攻擊類似的方法來檢測對人工智能系統的攻擊。

傳統的安全理念,例如驗證和清理模型的輸入和輸出,仍然適用于人工智能領域。